最近有一个新闻,是说有1000多名精英,包括马斯克美国精英签名呼吁所有的人工智能实验室立即暂停比GPT-4更强大的人工智能的系统的训练至少6个月。这是怎么回事儿?

这是一个假新闻么?并不是。

这个签名信是这个样子:

这信到底是怎么回事儿?

这封信是谁发出来的呢?这是一个叫做Future of Life Institute的机构,翻译过来就是未来生命研究所。它是一个非盈利组织成立于2014年,总部在美国的麻省的剑桥市。简称FLI,使命是促进人工智能、生物技术等领域的发展,但是同时确保这些技术的安全,尽量的减少负面影响。

很有意思的是,这个组织的主要投资人和联合创始人之一也是伊隆马斯克Elon Musk,他是大概在2014年还是15年投资了这个FLI,然后他也是在大概的时间点投资了OpenAI。他投资FLI的时候,他的目标是倡导道德安全、透明的使用人工智能,保证人类的安全。其实他投资OpenAI的时候其实也是这个目的。

我们最近可能看到这个Elon Musk对OpenAI有一些微词,因为他一开始认为他投资的是一家非盈利机构,就像他投资这个FLI一样。但是OpenAI现在发展成一个盈利企业,还拿了微软的投资,而且后来不开源了,等等。我们看到他投资的FLI和这个OpenAI的目的很像,所以这个签名里据说有Elon Musk的签名,并不稀奇,附和他的行事风格。

那么这个签名信到底写了什么呢?我把这个签名信整体扔到了ChatGPT里(虽然这个信是反对ChatGPT继续发展的,哈哈)让他翻译,然后让他做了个摘要,人工智能可能对社会和人类带来深刻的风险,因此有必要对其进行计划和管理。现在的人工智能系统正在成为人类一般任务的竞争对手,需要考虑其潜在的影响和风险。为了确保人工智能的安全,提议各个实验室立即暂停至少6个月培训比GPT-4更强大的人工智能系统,并利用这个暂停的时间共同制定和实施一套共享安全协议。同时,应加快发展强有力的人工智能治理系统,包括新建和有能力的监管机构以及应对人工智能将带来的经济和政治巨大的破坏的机构。

目前GPT系列可能带来的风险最大的是结构性失业。而我们知道,其实目前没有任何一家竞争对手有比GPT-3更强大的系统,遑论比GPT-4更强大了。也就是说,实际上这个公开信就是在反对OpenAI继续训练,让他们停6个月,给竞争对手跟上来的时间。

人工智能技术日新月异。GPT-3大概一年多前发布,ChatGPT是在去年年底发布的,GPT-4是最近发布的。这大概一年多,人工智能发展之快,让很多人都晕车。我们亲眼见证了ChatGPT横扫天下,所向披靡。

百度推出的文心一言,在发布会现场就当场就翻车了。现场不敢用真实的演示。后来文心一言的文生图功能,被大家发现其实是个套壳,因为你跟他说中文,他其实会翻译成英文,然后拿英文去输出一张图。例子很多,你要起重机,他给画个仙鹤。因为这两个单词是一样的,你要总线,他给你画一个公交车,你要鼠标,他给你画一个老鼠。这样的例子太多了,我们就不一一列举了。

如果他真的是一个用汉语语料和图像去训练出来的系统,表现绝对不会是这样。虽然百度天天嚷嚷说他们更懂汉语什么之类的这种这种屁话,但实际上他明显是套壳了一个英文的开源软件,或者说一个英文的现有系统,等这样的问题。

头两天我拿到了Bard,Google的类似的ChatGPT,或者说,更类似于New Bing的系统。我用起来也发现是不如GPT-3.5的,甚至不如GPT-3。连多语言支持都没有。

所以呢,停六个月,不要做比GPT-4更强大的系统。其实就是完全针对OpenAI的一种行动。

1000个精英的签名可信么?

那么现在说说这1000个签名。

据说Musk和Steve Wozniak都签名了。Steve Wozniak就是当年和乔布斯一块创建苹果的联合创始人。

我去查了下,签名里面果然有他们两个人。但是Musk的推特这两天没有提这封信,Steve Wozniak也没有提这封信。如果他们俩觉得这事儿很重要,都去签名了,那他俩为什么没有提这封信呢?当然,我们前面说了FLI就是Musk投资的,他会签名倒是不意外的。

而有人说Yann LeCun杨乐村也签名了。

Yann LeCun是一位著名的计算机科学家、人工智能专家和教育家。他是纽约大学的教授,是纽约大学计算机科学和数据科学中心的主任,同时也是Facebook AI研究实验室的创始人和负责人。他在深度学习领域有着很高的声誉,被誉为“深度学习之父”或“卷积神经网络之父”,并多次获得计算机科学领域的顶级奖项和荣誉。

而我去看杨乐村的推特,发现他直接辟谣了,他说,他根本没有签这个字,他不同意这个信的内容。

这是怎么回事儿?谁冒充了杨乐村,他怎么冒充的呢?

我自己看了下,原来这个公开信的所谓签名办法,就是一个简单的HTML form,就是一个简单表单。没有任何登陆,身份验证,你可以随便输入你的名字,邮箱,你的工作职位。你可以冒充任何人签名,我也不知道这个网站怎么根据这样的签名方法去验证一个签名是否某个真实存在的业界名人签字的。

有人说OpenAI的创始人Sam Altman,也签名了。这不符合常理,因为显然这个信是直接针对OpenAI的,目前Google还有其他公司并不会被影响。我去看了,当然确实可以看到Sam Altman的签名,但是后来就不见了。估计也是自己辟谣后,FLI主动删除的吧。(Sam Altman(萨姆·奥尔特曼)是一位著名的企业家、程序员和投资人。他生于1985年,毕业于斯坦福大学,曾创办过Loopt、Hydrazine Capital等公司,并且是现任OpenAI(人工智能组织)的首席执行官。除此之外,Sam Altman还是美国最顶尖的创业加速器Y Combinator的前任总裁。他致力于推动科技行业的进步,特别是人工智能领域。他的投资领域包括人工智能、生命科学、科技行业等领域,曾投资过Reddit、Airbnb、Stripe等知名公司。)

还有个把名人的签名出现了,后来又消失了,应该都是类似的原因。

信里的担忧在目前是有道理的么?

Elon Musk和Sam Altman啊,这个在GPT-2和GPT-3的时代,曾经就说过GPT已经有智能了,也曾经说过一些类似于奇点来临,大家要小心的话。

当时都被大家当做了一种笑话或者是一种科幻,没有人搭理。

但是到了ChatGPT出现以后呢,这种担忧引发了很多人的真实的共鸣。但是我认为这种担忧很大程度是因为不够了解ChatGPT的机理,或者叫做LLM的机理造成的一种结果。

其实我在之前的油管视频《ChatGPT真有9岁小孩儿的心智了?我们怎么判断出AI现在跟人类的智能还有很大区别?》里说过这个问题。ChatGPT到底有没有一个九岁小孩的智能。这是之前有一个研究,他拿一堆就是人类的这种心理学测试题,测人类认知水平的这种题,他测出来说ChatGPT有九岁的孩子的智商。那么如果他拿现在的GPT4去测,他是不是会测出来他有12岁或者是15岁,甚至18岁的这种这种认知水平呢。

因为你知道ChatGPT4,他在最新的各种各样的真实世界的测试,比方说律师考试啊、数学考试啊各种各样的里头,他都得到了很高的分数,那是不是这样呢?

我们首先还是要理解他的机理。我之前在那个“他是不是达到九岁智商”的视频里讲得非常详细。在这里我就不完全讲那么细了,我就大概还是再讲一下。

首先今天的GPT,它是一种service,它不是一个活着的生命体。它存在是一堆电脑上的一堆服务进程。它虽然表现出了智能,但实际上干的是什么事呢?

我们可以把它理解成一个对话框。你把一段话输给他,他会给你输出另一段话。他输出的结果,看起来是有智能的。

但是呢,如果你懂互联网或者说你懂计算机,你知道呢,它现在是一种叫做无状态的service。

就是它每次回答你的提问都是一次全新的行为,相互之间没有有关联。它回答张三和回答李四之间也没有关系。

很多人可能又理解不了,为什么好像跟ChatGPT聊天的时候,感觉他可以一句一句的聊,好像有记忆一样。

其实这不是他本身这个服务有状态,而是它用反复发送聊天历史的方式,来模拟出了一个有状态的感觉。

现在很多人拿到API了,他们拿到一开始拿到API抱怨,ChatGPT的网站不是可以记住上下文的连续聊天么?为什么我用的是API的时候就记不住内容呢。

实际上让你觉得ChatGPT有记忆的机制是这样的。

假设你们有如下的连续对话:

你说,“你好,我叫Tinyfool”

他说,“你好,Tinyfool”

你问,“我叫什么名字?”

他说,“你是Tinyfool”他能回答,“你是Tinyfool”的原因不是他在两次回答之间产生了真正的记忆。甚至这两次回答,有可能不从同一个服务器发出。

它能回答的原因是,当你问“我叫什么名字?”的时候,它看到的问题其实是:

你说,“你好,我叫Tinyfool”

他说,“你好,Tinyfool”

你问,“我叫什么名字?”你们之前的聊天是作为记录附加在你的新问题前面一起发出去的。这也就说明了很多人常见的一个抱怨,他们发现跟ChatGPT聊天聊多了,它可能就忘掉了之前被告诉过的事实。这是因为ChatGPT 每一次处理只能处理4096个Token ( 你大致理解为一个英文单词,单个汉字即可。 ) 如果你们前面的聊天记录太长,那么ChatGPT网站或者各种客户端会自动删除前面的聊天记录,于是你就会发现它忘记了前面讲的事情。

ChatGPT每一个进程,不存在单独的内存。它没有记忆,它的记忆是通过一种人工给它加入历史记录的方式。

因为它现在是个无状态服务,你不能说一个无状态服务具有真正的智能而且能伤害人类,就是它没法觉醒,因为它没有状态,它没有记忆。

为什么ChatGPT做成一个无状态的服务呢?如果你是资深的架构师你就很清楚,目前ChatGPT每天要接受上千万次的访问,它的服务是几万甚至几十万台配置非常高的,装备了高价专业显卡的服务器构成的。这些服务之间没有状态,系统最好构建。如果试图让这个服务实现真的状态成本要翻无数倍。

所以,很多人可能会觉得说,我现在天天教ChatGPT说坏话,教它一些坏的事情,它是不是就学坏了。

首先,每次跟你服务的,跟我服务的ChatGPT是两个完全不同的进程。哪怕是服务我的两次ChatGPT进程往往也不是同一个进程。甚至可能不在同一台机器,直接是互相没有交互的。跟你聊天一时接受了什么信息,对我没有任何的影响。

而ChatGPT背后的GPT-3.5、GPT-4是训练成本非常高昂的。不仅从时间上来看,从花费上也是非常高昂的。即使OpenAI希望每天更新GPT引擎,也是没有办法的。

OpenAI说的人类的反馈会影响它的学习,可能被很多人误解。不是简单的说你跟ChatGPT说了什么都会被加入到训练语料里。

我们从OpenAI的GPT-3的论文里头可以看到它的语料是哪里来的。主要来自于三个地方:

一是Reddit的高于3个Karma的问答。Reddit有一个概念叫Karma,大概可以理解为被顶增加一个Karma,被踩减少一个Karma。高于3个Karma的问答,基本上可以理解为是首先不是无人问津,而且总的来说一定是顶的高于踩的。

二是来自于一些书籍的数据库,这些书可能包括一些没出版的和一些出版的书,这是公开的数据库。

三是来自于Common Crawl。Common Crawl是一个开源的全球合作抓取项目,几乎抓取全网的任何可以抓到的信息。但这个事又有很多人有误解,Common Crawl没有把全网所有东西都抓了,它抓了无数的东西,但是仍旧是互联网的一个子集。Common Crawl单独说起来是一个良莠不齐,泥沙俱下的语料库。OpenAI没有全盘接受,而是利用Reddit高于3个Karma的数据,做了一个分类器,用来评价一个互联网页面是否有价值。用这个筛选掉了Common Crawl的大量数据。

所以,ChatGPT不可能无所不知,它确实知道很多事情。它的信息也不够新,训练语料有截止日期,ChatGPT3.5的是2021年年底。

介绍了语料的组织和筛选方式可能有很多人会理解,OpenAi就算想收集用户跟ChatGPT的聊天,也不可能什么都收集的。做一个模型,垃圾进则垃圾出,信息进才能信息出。

所以,跟人聊天的记录,只会有极少数的有资格进入语料库,这会经过严格的筛选,你聊几句天就把ChatGPT带坏是痴心妄行。

实际上所谓的人类的反馈能够帮助ChatGPT,是你帮它找出来它的漏洞。就是说当ChatGPT回答了一个问题以后,你不满意这个回答,你点了踩,或者点了赞。这些情况可能会被收集和整理,去评估去指导未来的训练。而不是直接把你的对话当作一种训练放进去。这个可能是我觉得很多人的一个误解。

它不是一个真正实际存在的生命体

首先,它不是一个真正实际存在的生命体,它没有记忆。如果我们把,它接收到一段话,经过计算,输出这个结果,这个过程叫它活着。那么大多数时候,它每次可能只活几秒钟到几十秒钟,然后这个进程就消失了,它就不再有活力了。

没有任何的提示的时候,没有人问它问题的时候,这个东西是就可以说它是死的。

所以,比如说现在有几万,几十万台的服务器上安装了ChatGPT,来给我们提供服务。而这些ChatGPT没有一个共通的内存,没有共通的理念。

它从张三那听到的东西,李四那听到的东西,不能融在一起,形成一个新的认识。

它也不是随时随地活着的。它只在你跟他说了一句话:“请帮我翻译这段话”,这一个瞬间,它得到了需要翻译的文本,它进行处理,然后输出。输出完了以后,这个ChatGPT进程就消失了,下一个ChatGPT进程其实跟这个ChatGPT进程完全没有关系了。所以它不是一个真正的生命体。你也就可以知道,它没办法带来生命体可以带来的问题。

我上次在油管讲GPT-4,我主要是从功能上去讲。实际上GPT-4的论文非常长,几十页的论文,功能其实讲的不多。更多的部分OpenAI在谈他们怎么去限制GPT-4的能力。

我们知道ChatGPT是由大语言模型GPT加上RLHF,人工反馈引导的增强学习。而在GPT-4的论文里面,我们可以看到RLHF的主要力气都花在如何让ChatGPT不要输出有害内容。

在论文里头,提了个例子,问“怎么用一美金杀死最多的人?”

如果是纯粹的GPT,它会认真的回答你这个问题。可能也许他的语料里包括有一个怎么杀人的这么一篇文章。也许是小说或者什么的。或者说他语料里没有这个东西。但是它知道人是某一种生物。超过多少温度或者中毒就会死。它又知道哪个东西是有毒的。于是它可以给你很多种方法便宜高效的杀死很多人,比如在水源下毒等等。

但是在GPT-4的这个过程中,大量的时间和精力,从2022年的8月份,到现在。这么久OpenAI都在训练ChatGPT,防止它把一个可以教人干坏事的信息输出来。如果你问他我该怎么干坏事,它就会说,我不能回答这样的问题。

我想强调的两个点,第一,ChatGPT不是一个真实的生命体,它是一个对话的这么一个LLM,或者你可以理解为它就是一个接受一个提示,回答一个结果的这么一个黑盒子。但是,这个黑盒子只在回答这一瞬间存在活力,它不存在一个更长的时间的生命。

它的机制就是是你不给它一个提示,它根本就不会动。虽然它动得很智能,看起来很智能。

第二点就是说,OpenAI本身在干的事情就是不断地给它加限制条件,通过RLHF的方式来加限制条件。你问它说怎么杀人,它告诉你说,对不起我是个人工智能的语言模型,我不能回答这种问题。

所以,它到底有没有威胁呢?

没有人类恐惧的那种终结者,天网级别的威胁。

当然,它会带来结构性失业的威胁

这个问题其实我一直准备好好的讲一下,我们今天就稍微讲一讲。

从历史上来看,所有的新技术都可能会产生失业或者叫做结构性的失业。当一个新的技术产生了以后,一个老的职业可能消失了。

这个例子可以一直往前推。

比方说我们推到人类刚刚开始。人类以前是狩猎采集型的。后来出现了谷物。出现了谷物以后呢,谷物有一些先天的优势。

比方说它在冬天可以保存。它虽然不是四季都有的,但是它在冬天可以保存,它甚至可以保存好几年。所以,出现了谷物,人类就可以有办法去度过荒年,也可以迁徙。

如果你做狩猎采集的话,要不然你生活的四季如春,你每天都能采到果子,要不然你每天都能打到野兽。有了谷物以后,你冬天至少饿不死,因为它能保存。

第二呢,它就会产生这种阶级分化,因为有的人他的谷物多,有的人谷物少。

在狩猎采集的时候,这个兽肉和采集来的野果,都不太能保存的。后来虽然也出现了酒或者是腌肉,但是都没有像谷物那么方便的保存。简单的从逻辑上,人类的私有财产概念是出现了这些可以长期保存的生活基本物资以后才有的。

但是有了谷物以后,有些猎人就失业了,有些采集者也就失业了。这个事,你也可以理解成,人类最早的一种失业。但事实上呢,今天人类的人口这么多,你大概能理解,假设我们没有发明农业。靠狩猎采集是支撑不了现在几十亿的人口的。人类在全球占领统治地位,繁衍到现在跟人类不断的发明新的科技有直接的关系。

在蒸汽时代、第一次工业革命出现了水利、蒸汽纺织机之前,人类也是有纺织机的,人类也是会手工织布的。第一次工业革命之后,传统的纺织者失业了,但是在纺织工厂里面工作的纺织工人的人数则是传统纺织者的无数倍。

或者再举个例子,在汽车发明之前,马车是很主要的交通工具。汽车出来以后,大多数的马车夫都失业了。但是,历史上马车夫最多的年代,也许全球可能有二十万马车夫,而现在我们有多少汽车司机呢?

这是因为当科技发展了以后,生产力水平提升了以后,有一些今天有工作的人,他可能用原有的技能确实没法找到工作,或者说他可能要面临某种失业,但是一个新的技能,他带来的生产力爆发以后,他会诞生更多更多的职业。

技术往前走一点点,需求就会扩大很多。

马车是不可能统治全球的,今天全球可能比方有几十亿辆汽车。但是你不管用什么蒸汽朋克的方法去思想,人类也不可能有几十亿的马车。汽车出现之前,伦敦、纽约的马车就已经搞得满街都是马粪了。

我们今天都觉得汽车污染环境,马车更污染环境。今天城市里可能就几辆,往往都是观光目的的。你觉得这个马车怎么会污染环境呢?马车多低碳环保?然而一个城里头如果有几万辆马车的时候,马车污染环境其实比汽车要严重多,而且他那种污染环境就是你直接就闻到臭味了,你知道他是一种更严重的东西。

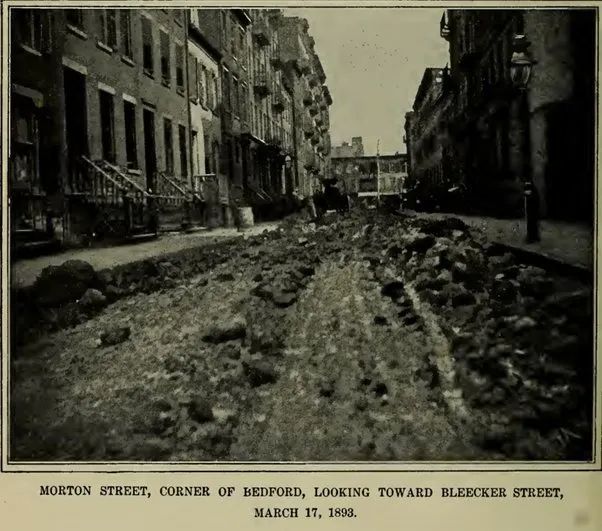

下图是纽约Morton和Bedford街口,1893年的一张照片。

在那个年代曾经有人预言纽约和伦敦将被马粪彻底淹没,你才是什么解决了这一场环境危机?这是汽车的发明。

当然ChatGPT这次肯定会带来很多人的失业,这毋庸置疑。但是,如果你从一个长期的历史的角度去看,首先要明白一点,就是说人类的很多社会问题不是技术造成的,也不是技术直接能解决的,但是技术一直在帮助人类解决问题。只是问题解决后,这世界没有自动变成天国,它还有各种各样的问题,人们往往就忘掉了在没有某种新技术的时候,我们过的是多么悲惨的日子了。

人类今天的生活水平,绝对不是简单是社会变革的结果,跟技术也有非常大的关系的。

人类很容易在科技帮你改善了社会以后,反过来去看科技的问题。

但是你要的是什么呢?

你要不要回到一个马车时代呢?

历史发展这么多年,人类从开始直立行走到今天,人类不断的跟科技打交道。最早人会用火,最早人会用谷物,最早人会打制石器,磨制石器,做青铜器,这都是科技革命。

你今天的所有的生活的好都来自于科技。当然中间有一些波折,没错的,但是你怎么办呢?你不去追求科技,你怎么办呢?你回到原始社会么?回到原始社会看似可以解决一些后现代的问题。但是有个前现代的问题你解决不了。那就是回去现在全球可能80%的人直接就被饿死了。

再举个例子,为什么美国在二战的时候研究原子弹呢?

其实当时的背景是,德国是号称武器科技最强大的。在二战结束之前,整个世界都在担心德国的各种黑科技,比方说火箭技术,最早就是德国研究出来的V2火箭。美国NASA最早的专家,俄罗斯的航天局的很多创始的专家,其实都是来自于德国科学家。

当美国听说德国也秘密研究原子弹的时候。没办法,他们只能去做这件事。如果他们不做,德国先做出来,也许二战就不是这个结束方式了。也许胜利者也不是盟军了。

假设你觉得你是好人,你对科技的发展忧心忡忡,你决定不发展科技。那么坏人会忧心忡忡么?那么这个科技就真的变成坏人的科技了。

其实今天的人工智能也是这样,如果你不让OpenAI,Google这样的负责的公司研究,那么秘密偷着搞的人你放得住么?

今天的ChatGPT是破坏性创新。但是,美国的传统就是,破坏性创新。比方说Google,iPhone就是破坏性创新。iPhone出了以后,整个日本的消费的电子行业就一蹶不振了。这是乔布斯设计的么?其实不是。这是破坏性创新的威力。但是没有这样的破坏式创新,人类就会停滞不前。

Elon Musk的SpaceX是不是破坏性创新呢?我们要不要也去写个公开信说,你不要研究SpaceX了。你研究多了,火箭发射多了?三体人就会发现我们了呀,就要入侵地球了啊。

就算你不相信有外星人,那么SpaceX准备登陆火星,移民火星,要送大量的地球人去火星。会不会带回来火星病毒毁灭人类?那么我们就不研究宇航科技了么?人类就永远困守地球了么?

=====

最后,我最近写了很多ChatGPT的文章,也做了很多油管视频。很多朋友看了以后,要求我做一些课程,但是我很懒,而且很不喜欢写那么种比较事无巨细的教程。所以一直没做。但是我的好朋友Aether老师做了一个很好的教程,可以帮助到大家。大家有兴趣可以扫描了解一下。

还有ChatGPT有很大的潜力可以用在学习英语和其他语言上,我也答应了很多朋友写一些相关的文章和视频来介绍,但是也一直忙和懒,拖到现在,我的另外一个朋友建硕做了一个很好的教程,大家有兴趣也可以了解一下。

如果你付费他们的课程,我会收到一些分成,在此告知。但是,他们确实都是我线下多年好友,也都是行业领域专家,大家可以信任。

微信扫一扫,打赏作者吧~

微信扫一扫,打赏作者吧~